I. Introduction

Le printemps est là et telles les fleurs qui l’annoncent, les demandes de participations aux questionnaires pour les TFE et mémoires commencent à fleurir sur nos timelines.Poussés par l’aspect novateur de faire des recherches sur des choses que personne n’aurait jamais faites (alors que bien souvent, il s’agit du contraire), les étudiants choisissent un sujet sur les réseaux sociaux. ( Quand leur choix ne se porte pas sur ce sujet, car ils pensent pouvoir mener leur recherche depuis leur fauteuil) Passons le biais qu’ils ont dès le départ dans leur petite tête, à savoir qu’ils sont convaincus qu’il faut que leurs résultats montrent la puissance des réseaux sociaux ou correspondent à ce qu’ils ont lu sur leurs blogs favoris, ils ne se rendent même pas compte que leur dispositif de recherche est également biaisé.

En effet, comme méthode de recherche, il y a véritablement deux méthodes de recherches choisis par une majorité d’étudiants : les entretiens ou les sondages. Or les deux amènent inévitablement d’énormes biais s’ils ne sont pas exécutés adéquatement:

- Pour ces premiers, ils sont généralement menés auprès de consultants spécialisés en Web qui manquent de regard critique sur les réseaux sociaux, tant ils passent leur vie à recommander ces solutions. Ils sont, la plupart du temps, choisis, car ils apparaissent comme l’expert de la segmentation social media choisie comme sujet d’étude et sont surtout beaucoup plus disponibles que les personnes qui apporteraient un regard critique. Plus disponible, car l’étude qui sera réalisée les intéresse fortement et ils peuvent en participant, avoir une copie de l’étude pour leur apporter des informations qu’ils n’ont plus le temps de chercher par eux-mêmes. Au pire, ils chercheront même à influencer le chercheur afin que celui-ci dresse des résultats conformes à ce que celui-ci vend afin de s’empresser de se servir de l’étude en question pour prouver à son client le bien fondé de son approche. Une analyse par entretien des réseaux sociaux emmène donc un biais qui ne pourrait être compensé que par un entretien auprès d’une personne qui a une vue totalement différente, ce qui n’est la plupart du temps pas fait, car autant, l’identification d’ “expert” est facile via les blogs et Twitter, autant l’identification de gens qui sont détracteurs, est beaucoup moins aisé.

- La deuxième méthode, très peu choisie auparavant (cela prenait beaucoup de temps pour la récolte des résultats, pour inscrire les données et les traiter), est, avec l’arrivée de solutions faciles comme les formulaires Google, devenue LA méthode refuge des étudiants. Deux semaines avant la date d’échéance, l’étudiant remarque qu’il est en retard et qu’il ne pourra jamais réaliser une étude approfondie. Il se dit donc qu’un sondage est la solution facile pour avoir des enseignements sur son sujet de recherche. Quelques questions écrites sur un coin de table plus tard (aïe les biais en plus), il lui faut maintenant de l’échantillon ( pour ne pas dire du bétail) et cela tombe bien :l’étudiant est sociable et dispose de 600 amis Facebook mobilisable.

Or, ces 600 amis sont issus d’un milieu proche de l’apprenti chercheur ce qui biaise les résultats au point de vue sociodémographique. Les résultats correspondants sans doute aux habitudes de celui-ci, il sera plus conforté quant au fait que son sondage correspond à la réalité.

Cependant, en plus des biais nommés auparavant, lorsqu’on fait une étude sur les réseaux sociaux, l’utilisation de sondage sur Internet est déjà un énorme biais de representativité, mais le partage par Facebook en génère encore plus. La pratique de l’ordinateur et d’Internet leur apparaît tellement évidente alors qu’ils en oublient que 13% de Belges de 16 à 74 ans n’ont jamais utilisé un ordinateur et 14% n’ont jamais navigué sur l’internet. (2011) A cela il faut encore enlever tous les gens qui ne sont pas sur Facebook. Le biais de l’échantillon est énorme. Les questions ne vont faire que renforcer encore plus ce biais. Combien de questions sur les réseaux sociaux qui ne posent pas la question “Êtes-vous sur un réseau social ?” ? (Comme lors d’un sondage téléphonique où l’on demanderait possédez-vous un téléphone ?)

La nature des gens qui répondent aux sondages laissés sur une timeline est déjà bienveillante, quoi de plus normal qu’ils déclarent dès lors partager beaucoup ? De plus, le temps passé sur les réseaux sociaux sera d’office plus haut que la moyenne puisqu’ils prennent le temps de répondre à un sondage laissé sur leur timeline. Bref, je m’arrête là, vous aurez compris où je vous mène.

Les études sur les réseaux sociaux menées par les apprentis chercheurs sont donc la plupart du temps totalement biaisées.Mais allez leur dire que si l’on veut étudier les réseaux sociaux, il faut aller au supermarché du coin afin d’interroger des personnes sur leurs habitudes… ( et encore, il y aurait également le biais de lieu, les grandes villes étant plus connectées que les villes de campagne)

Mais je ne suis pas en train d’écrire ces mots pour dénoncer une situation que tout professeur ayant eu des mémoires à corriger connaît très bien. J’écris ceci parce que de la part d’étudiants, en apprentissage de recherche, on peut comprendre ces erreurs.

Par contre, on ne peut pas comprendre comment certaines recherches que vous partagez tous sont des études à deux euros 50 qui ne veulent rien dire et qui pourtant ont l’air de structurer votre stratégie sur les réseaux sociaux, si j’en juge le nombre de mentions “intéressant” que vous y apposez.

II. Analyse

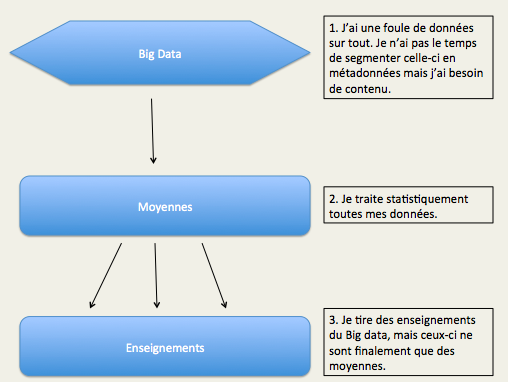

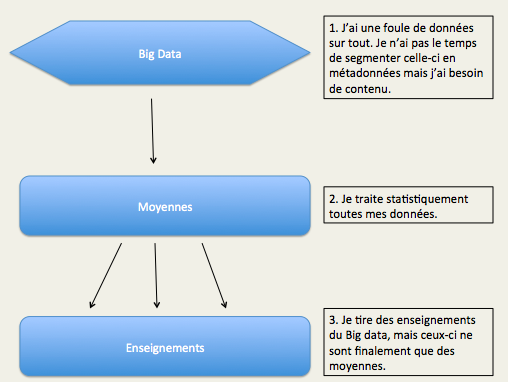

Aujourd’hui, on est à l’ère du brand content à outrance. Seulement, on publie tellement de contenu qu’il faut créer une information intéressante et qui soit partagée par le plus grand nombre. Dans ce but, certaines entreprises publient des études qu’elles tirent de leur Big Data.

Le Big Data est à la fois une des plus grandes opportunités du moment pour les entreprises et également le fossé qu’elle est en train de creuser sous leurs pieds.

D’une part, parce que le Big Data n’est que le reflet et les indicateurs au mieux d’une situation présente, au pire d’une situation passée. La vision d’une entreprise ne pourrait être tirée du passé ou du présent, mais de ce que le futur pourrait être. D’autre part, parce qu’elle n’en tire que des enseignements banals, qui sont biaisés la plupart du temps, car on ne traite pas les résultats comme il le faudrait. Je vais vous montrer pourquoi toutes ces études qui sont sensées tirer des enseignements ne tirent finalement que du flan.

Petits florilèges des études que j’ai vues:

Wow, ça fait peur. Si j’utilise trop de hashtags, cela va tuer ma marque. Ça c’est un article qui claque et qui, heureusement, est arrivé dans mon processus de veille ce qui fait que je ne me ferai point avoir !

J’imagine les créateurs chez Mashable en train de discuter:

- “Il nous faut une étude pour prouver notre sérieux”

- “Oui, mais sur quoi ?”

- “Je ne sais pas. Mais je sais qu’on a une nouvelle case Excel dans nos analaytics Social Bakers.”

- “Ah oué ?”

- “Oué , c’est sur les hashtags, ça les compte automatiquement”

- “Ah bah faisons cela là-dessus. On va prendre toutes les données qu’on a, on va voir en fonction de leur interaction et voir en fonction du hashtag.”

- “Oué c’est good ça, on a juste à faire 4 manipulations sur Excel et on aura du reach.”

Et là on obtient :

Avec le gras qui te dit quoi faire (chez Mash/able, on est capable de mâcher le travail t’inquiètes) , sans oublier de t’éblouir avec le nombre 200 000, pour créer la confusion avec le fait qu’avec un échantillon de 1080 personnes, on est capable d’avoir un bon sondage représentatif.

Bref, assez ri. C’est une étude qui ne veut absolument rien dire. On prend une masse de messages, sans les différencier en leur appliquant un facteur ( le nombre de hashtags), et on induit que hashtag = interaction killer.

Pourtant, on ne regarde pas la nature du message ni l’émetteur. Si cela se trouve, les émetteurs des hashtags étaient des bots ou ceux qui n’utilisent pas de hashtag sont des grosses marques qui posent des questions sur votre petit déjeuner ou des lolcats toute la journée. On n’étude rien, on constate.

Pourquoi est-ce une si grosse erreur? Parce qu’avec le Big data, on part des résultats pour y appliquer une question alors qu’il faut partir de la question pour avoir le résultat.

C’est mis en style titre 4 pour que cela soit visible si vous faites une lecture éclair. En clair, pour faire de la recherche, répondre à une question et tirer des enseignements, il faut voir qu’est ce que l’on veut observer et créer un laboratoire stérile ( sans influence extérieure) pour tester une hypothèse.En clair, il faut partir d’une disposition identique et y appliquer une variable pour constater si celle-ci a une influence. Si l’on veut voir si les hashtags tuent l’interaction, il faut donc partir d’un post provenant d’un même émetteur, avec un même public, un même sujet, un même réseau horaire et y appliquer la variable hashtag. (avec, sans, avec 2/3/4/5,etc.)

Reprise d’une “étude” de social bakers:

Même phénomène, je te prends toutes les pages qu’on a en stock (grande spécialité de socialbakers), je te fais une bonne moyenne segmentée AVEC ou SANS bouton Message, et j’en déduis qu’il ne faut pas de bouton message. Facile non ?

Seulement, ne serait-ce pas parce que les entreprises qui utilisent le bouton message n’ont en fait pas beaucoup de choses à traiter comme question ? Cela ne semblerait-il pas logique qu’une marque avec beaucoup de questions se décide à ne pas utiliser de bouton message, car elle veut en diminuer le nombre en laissant ceux-ci visibles au cas où quelqu’un trouverait le même problème que lui ? Enfin, moi je dis cela comme ça..

3. Le guide Michelin des études biaisées sur les réseaux sociaux : LA TAILLE IDÉALE DES PUBLICATIONS

Véritable florilège pour tout savoir sur la taille qu’il vous faut afin de pénétrer au mieux votre marché:

Il y est indiqué la taille parfaite de votre publication, et ce pour les différents médias. Là encore les études sur Facebook et Twitter utilisent une somme astronomique de tweets de plusieurs marques et comptent l’engagement par rapport à ceux-ci. Là encore, rien n’est segmenté.

- Le message peut être un LOLcat influençant grandement l’étude que cela ne serait pas pris en compte.

- Le message peut également être un texte institutionnel que vous n’en sauriez rien.

- Une marque suscitant par essence peu d’engagement peut totalement faire plomber l’étude dans la mesure où elle va influencer, par sa manière de poster, les résultats. Ainsi, toutes sortes de marques, de tout secteur sont présentes.

Bref les biais sont énormes, mais pourvus qu’on ait du chiffre et qu’on sache quoi faire pour poster ce qu’il faut faire le mieux.

Ces études pousseront le bouchon au maximum en grossissant dans leur infographie leur biais ostensiblement comme le fait de placer le mot RT en début du message parfait, car “cela pousse au RT” . Merci de l’info, les gars, je ne m’en doutais pas du tout. Par cet acte, ils montrent l’imbécillité de leur étude à son paroxysme vu qu’ils prouvent qu’ils ont pris tous les tweets contenant dans leur message “RT” ce qui fait que tout message appelant au RT influencera grandement les résultats.(EX: un message avec PLZ RT aura déjà 5 caractères et forcement un message plus long)

Le culte du message parfait, entre 90 et 100 caractères, fait presque penser à ces standards de la beauté où il faudrait avoir le poids idéal, la taille idéale, mais ne plus être soi-même au nom de la sacro-sainte statistique.

Comme une dégénérescence qui nous ferait revenir au 19 ème siècle, au côté d’Adolphe Quetelet et son homme moyen, c’est-a-dire l’homme que finalement personne n’est étant donné qu’il s’agit d’une moyenne et non d’une réalité en tant que telle.

L’article pousse le vice jusqu’à nous proposer plusieurs études, avec chacunes des chiffres différents qui nous font penser à toutes les études de coach en recrutement personnel qui ont mené leur propre étude, et qui arrive avec des chiffres tels que 45% des gens ont raté un emploi à cause d’une photographie sur Facebook et ce, alors que la plupart des RH ne daignent même pas encore regarder un pauvre profil Linkedin. (En Belgique, tout du moins)

Des solutions existent même pour voir les heures et jours des concurrents, comme Page Karma, pour connaître le temps qui serait idéal. Or, si tout le monde publie au même moment, il y a un bouchon énorme sur les timelines. De plus, quid si tout le monde utilise ce programme ? Nous aurions alors une situation ubuesque où tout le monde publie au même moment, non pas par besoin, mais parce que tout le monde le fait ainsi.

III. Conclusions

Les études sur les réseaux sociaux reposent sur une mauvaise utilisation des Big datas.

Au lieu de dresser des constats, ces études sortent de leurs champs opérationnels en dressant des recommandations erronées parce que bourrées de biais, elles n’étudient jamais le phénomène pour lequel elles dressent des recommandations.

Afin de dresser des constats sans biais, il n’existe que le laboratoire stérile auquel on appliquerait les changements de variable.

Ce laboratoire, c’est votre marque, vos espaces d’expressions, votre territoire, votre manière de parler et les informations que vous voulez publier. Dès lors, les seuls tests qui vous donneront les recommandations adéquates à propos de phénomènes tels que les hashtags ou la longueur de publication sont ceux qui auront été observés sur vos publics, votre marque et votre ligne éditoriale.

Le constat que je dressais déjà dans la nécessité de la DO NOT LIST du community manager est plus que jamais d’actualité: il n’existe pas de recette spéciale, de posts parfaits, de longueur parfaite, il n’existe que ce que vous allez faire d’un outil à votre disposition.

L’engagement est un indicateur, une mesure et non un but. En cherchant l’engagement, vous faites comme ces études en partant d’un résultat pour les traduire en actions alors que ce sont les actions qui doivent générer un résultat. Sus à la vision presque robotique et artificielle de la publication sur les réseaux sociaux qui est une politique de bas étage, car ce qui importe est la relation avec les publics et ce que la marque veut publier, que cela soit en une image et 0 caractère ou dans un article de blog de 135 000 mots importe peu. Ce culte du KPI de l’engagement est en train de mener droit dans le mur certaines marques et certains agences.

Ces dernières sont tels ces étudiants qui pensent pouvoir étudier les réseaux sociaux depuis le fauteuil de leur bureau alors qu’il faut avoir une vision globale en allant dans le vrai monde, dans la vraie vie, au contact des gens, au coeur de la relation sans l’influence du moindre biais afin de mesurer le véritable impact des réseaux sociaux , la pratique de ceux-ci et ce que cela apporte à une marque. Aucun KPI comme l’engagement, le nombre de likes ou de partages ne pourra mesurer l’impact du community management d’une marque aussi bien qu’un bon vieux questionnaire rempli par les clients ne pourra le faire.

Saper Vedere

Saper Vedere